mar 5, 2019 - Zhuang Liu: Rethinking the Value of Network Pruning, arxiv, 2018

Description:

本文重新思考了剪枝的意义,并得出有趣的结论: 经过训练-->剪枝-->微调的方法,即基于权值重要性/显著性方法进行剪枝,往往只能得到比随机初始化权重进行重新训练的类似或者更差的性能,这意味着:1)训练大型的过度参数化模型通常不需要获得有效的最终模型(预训练模型);2)学习大型模型的“重要”权重通常对小的剪枝模型 are typically not useful. 即不起很大作用.

3)删减架构本身,而不是一组继承的“重要”权重,对最终模型的效率更为关键,这表明在某些情况下,删减可以作为架构搜索范式。

本文还比较了“彩票假设”(Frankle&Carbin 2019),发现在最优学习率下,Frankle&Carbin(2019)中使用的“中奖票”初始化不会带来随机初始化的改进。

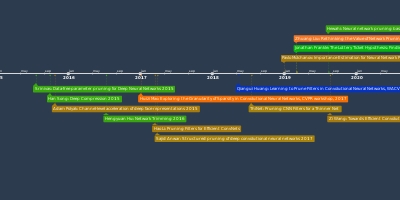

Added to timeline:

Date:

mar 5, 2019

Now

~ 6 years and 7 months ago